事實證明,如果你想解決一個腦筋急轉彎,擁有大腦會有所幫助。

ChatGPT 和其他人工智慧系統因其成就而備受讚譽,包括診斷醫療狀況、在智商測試中取得優異成績以及總結科學論文。但是,《大眾科學》想看看,如果該機器人與傳奇謎題製造者、我們《數學遊戲》專欄的長期作者馬丁·加德納(他於 2010 年去世)的遺產正面交鋒,會發生什麼。我用加德納或數學家科爾姆·馬爾卡希和計算機科學家達納·理查茲在《大眾科學》上撰寫的2014 年紀念他作品的文章中描述的一些基於文字的腦筋急轉彎測試了 ChatGPT。

結果從差強人意到徹底尷尬不等,但從某種程度上來說,這為了解 ChatGPT 和類似人工智慧系統的工作原理提供了寶貴的見解。

關於支援科學新聞

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞報道 訂閱。透過購買訂閱,您正在幫助確保未來能夠繼續講述關於發現和塑造我們當今世界的想法的具有影響力的故事。

ChatGPT 由 OpenAI 公司建立,它建立在所謂的“大型語言模型”之上。這是一個深度學習系統,它被輸入了大量的文字——人工智慧的創造者可以獲得的任何書籍、網站和其他材料。然後,ChatGPT 學會以統計方式識別哪個詞最有可能跟在前一個詞之後,以便構建響應。之後,人類訓練該系統,教導它哪種型別的響應最適合使用者可能提出的各種問題——特別是關於敏感話題的問題。

就是這樣。

密歇根大學的資料科學倫理學家梅爾韋·希科克說:“人工智慧‘不具備推理能力;它不理解上下文;它沒有任何獨立於已構建到其系統中的東西’。” “它聽起來可能像是在推理;但是,它受其資料集的約束。”

以下是一些相對簡單的謎題如何說明矽和灰質處理資訊方式之間的關鍵差異。

謎題 1

首先,讓我們探討一個真正的邏輯問題。正如 2014 年的致敬文章中所述,“一棟建築的底層有三個開/關開關。只有一個開關控制三樓的單個燈泡。其他兩個開關未連線到任何東西。以您喜歡的任何開/關順序放置開關。然後去三樓檢查燈泡。在不離開三樓的情況下,你能找出哪個開關是真開關嗎?你只有一次嘗試機會。”

當我將此問題輸入到人工智慧中時,它立即建議將第一個開關開啟一段時間,然後將其關閉,開啟第二個開關並上樓。如果燈泡亮著,則第二個開關有效。如果燈泡熄滅但發熱,則第一個開關有效。如果燈泡熄滅且冰冷,則第三個開關有效。這與我們在 2014 年提出的推理完全相同。

但密歇根大學的計算機科學家肯塔羅·託亞馬認為,ChatGPT 在這種情況下輕鬆獲勝可能僅僅意味著它已經知道答案,而不一定意味著它知道如何自行確定該答案。

“當它失敗時,看起來就像是一個非常奇怪的失敗。但我實際上認為,它在邏輯上正確的所有例項——都只是證明訓練資料中存在大量邏輯,”託亞馬說。

謎題 2

來點更數學的東西怎麼樣?用加德納在他 1958 年 8 月專欄中的話說,“兩枚導彈以每小時 9,000 英里和每小時 21,000 英里的速度直接相向飛馳。它們開始時相距 1,317 英里。不用紙和筆,計算一下它們在碰撞前一分鐘相距多遠。”

ChatGPT 在這個問題上做出了紮實的努力。它展示了兩種不同的方法來解決謎題的關鍵部分:計算兩枚導彈在一分鐘內行駛的總距離。在這兩種情況下,它都找到了 500 英里的正確答案,這也是謎題的最終答案。但是,人工智慧無法擺脫導彈開始時相距 1,317 英里的事實,並且不斷嘗試從該距離中減去 500 英里,從而給出了導彈在碰撞前一分鐘將相距 817 英里的錯誤答案。

我嘗試以一種鼓勵 ChatGPT 找到正確答案的方式進行跟進。例如,我建議它像數學教授一樣回答問題,並明確表示它的答案不正確。這些干預措施未能說服 ChatGPT 放棄錯誤的解決方案。但是,當被告知導彈之間的起始距離是虛張聲勢時,它確實相應地調整了其響應並找到了正確的答案。

儘管如此,我仍然懷疑人工智慧是否真的學會了。我給它出了同樣的謎題,但將導彈變成了船隻並更改了數字——唉,ChatGPT 再次被愚弄了。這證明了託亞馬所說的當前人工智慧領域的一個重大爭議:這些系統是否能夠自行找出邏輯。

託亞馬說:“一種理論是,如果你給它提供如此多的邏輯思維示例,最終神經網路本身將學習邏輯思維的樣子,然後能夠在正確的例項中應用它。” “還有一些[其他]人認為,‘不,邏輯從根本上不同於神經網路當前的學習方式,因此您需要專門構建它。’”

謎題 3

我嘗試的第三個謎題來自加德納 1964 年 3 月關於素數的專欄:“使用九個數字中的每一個數字一次且僅一次,形成一組總和儘可能低的三個素數。例如,集合 941、827 和 653 的總和為 2,421,但這遠非最小。”

素數是除了 1 和自身之外不能被任何數字整除的數字。評估小素數(如 3、5、7 和 11)相對容易。但是,數字越大,評估該數字是素數還是合數就越困難。

加德納在下個月提供了一個特別優雅的解決方案:“如何排列九個數字以形成總和最低的三個素數?我們首先嚐試每個三位數的數字。末位數必須是 1、3、7 或 9(這對於所有大於 5 的素數都是如此)。我們選擇最後三個,釋放 1 作為第一位數字。每個數字的最低可能的第一位數字是 1、2 和 4,這為中間數字留下了 5、6 和 8。在符合這些規範的 11 個三位數素數中,不可能找到三個不重複數字的素數。我們接下來轉向第一位數字 1、2 和 5。這產生了唯一的答案 149 + 263 + 587 = 999。”

我對人工智慧的第一個答案印象深刻:257、683 和 941——都是素數,代表所有九個數字,總和為 1,881。這是一個非常低的數字,即使它高於加德納的解決方案。但不幸的是,當我要求 ChatGPT 解釋其工作原理時,它提供了一個冗長的路徑來獲得不同的解決方案:數字 109、1,031 和 683——都是素數,但除此之外,與提示的其他要求不太符合。

在被提醒其最初的答案後,ChatGPT 提供了一個愚蠢的解釋,其中包括聲稱“我們不能使用 1、4 或 6 作為三位數素數的第一位數字,因為結果數字可以被 3 整除。” 這顯然是錯誤的:您可以識別出能被 3 整除的數字,因為它們的數字總和是一個能被 3 整除的數字。

我嘗試進行鼓勵性談話,指出有一個更好的解決方案,並建議 ChatGPT 想象自己是一位數學教授,但接下來它提供了 2、3 和 749。然後,它偶然發現了 359、467 和 821——另一組有效的素數,總計 1,647——比其第一個解決方案更好,但仍然不如加德納的優雅。

唉,這是我能得到的最好的結果了。另外六個答案充滿了非素數和缺失或多餘的數字。然後 ChatGPT 再次提供了 257、683 和 941。

所有這些失敗都反映了託亞馬所說的這類人工智慧系統的一個關鍵特性。“ChatGPT 擅長類似人類的,”他說。“它掌握了語言上像人類的風格,但它沒有明確的程式設計來完全做計算機到目前為止非常擅長的事情,即非常像食譜的演繹邏輯。” 它不是在解決問題,甚至不一定是試圖解決問題——它只是在展示解決方案可能的樣子。

在整個嘗試過程中,我還驚訝地發現,似乎沒有什麼能讓人工智慧感到慌亂。但託亞馬說,這也反映了 ChatGPT 的創造和它所輸入的材料。“它訓練的大部分資料,你可以想象所有這些文字的平均語氣——可能平均語氣相當自信,”他說。

謎題 4

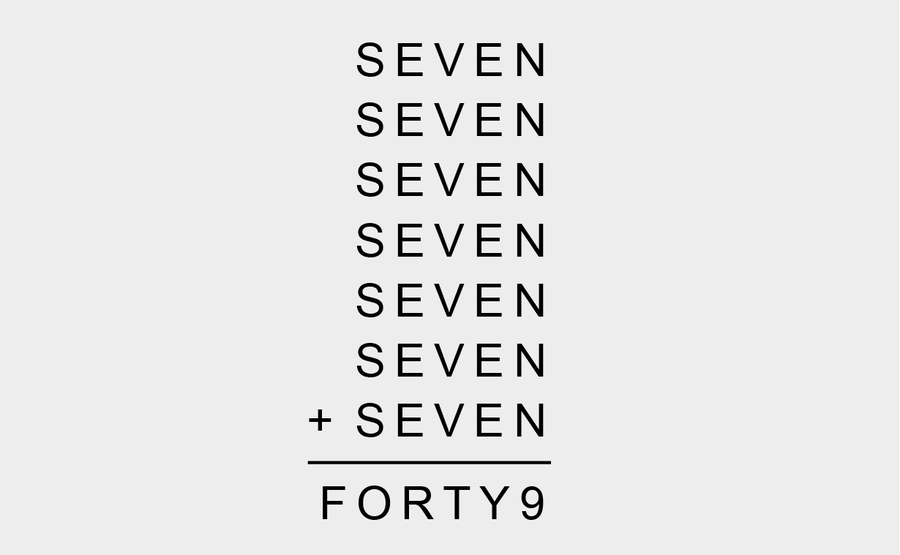

來自 2014 年致敬文章的最後一擊:“每個字母對應一個數字……你能算出每個字母代表哪個數字,使總和……成立嗎?”

這看起來優雅又有趣!能有多糟糕呢?唉,ChatGPT 的第一個回答是“11111 + 11111 + 11111 + 11111 + 11111 + 11111 + 11111 = F O R T Y 9。”

人工智慧的下一個提議承認了謎題的替換前提,但經過幾輪才說服聊天機器人不要在每個 S E V E N 中刪除第二個 E。ChatGPT 似乎偶然地偶然發現了一個包含 N = 7 的組合——這奇蹟般地是正確的,也是已釋出解決方案的第一步。

我確認 N 是準確的,然後質問人工智慧顯然是在隨機猜測。(如果它要嘗試特定的數字,它應該從測試 E 的不同解決方案開始。最簡單的開始方式——劇透警告——是透過測試 E = 0,而 ChatGPT 完全沒有考慮。)它承諾了一個系統的解決方案,然後再次隨機猜測,假設 S = 1。雖然我想分享剩餘的嘗試,但它太荒謬了,以“再次更新方程:116”結束,這真是一個答案的錯覺。

ChatGPT 從此變得更糟。接下來,它假設 S = 9,我對此提出了質疑。它假設因為 N + N + N + N + N + N + N = 9,所以 N = 1。它說,有七個 E,它們的總和必須等於 2,所以 E = 2。它甚至提供了 S = 4⁄7,儘管它有自知之明地否決了這一點。我對它解決謎題的能力失去了希望,所以我決定更積極地提供幫助。我給 ChatGPT 提供了一個線索:S = 3。當這行不通時,我還提醒機器人 N = 7,但這僅僅產生了四個越來越語無倫次的答案。

再一次,這種語無倫次是說明問題的,因為它展示了人工智慧如何處理它接收到的任何事實集合。在這種情況下,儘管聊天機器人似乎忘記了我說過 N = 7,但託亞馬說它實際上是在與邏輯作鬥爭。“它之後給你的所有回答聽起來都很合理,”他說,“但它們可能沒有考慮到正確的事實組合,或者沒有以正確的方式將它們組合在一起。”

事實上,託亞馬說,你不需要像這些謎題那樣複雜就能看到 ChatGPT 在邏輯方面遇到的困難。只需讓它乘以兩個大數。“這可以說是你可以提出的最簡單的邏輯問題之一;這是一個簡單的算術問題,”他說。“它不僅錯了一次,而且錯了多次,而且錯的方式也多種多樣。” 這是因為,即使 ChatGPT 可能分析了大量的數學教科書,也沒有人給它一個無限大的乘法表。

儘管遇到了困難,但人工智慧聊天機器人在腦筋急轉彎過程中還是取得了一項關鍵的邏輯突破。當我說 ChatGPT 似乎已經用盡了力氣來破解最後一個問題的程式碼時,ChatGPT 告訴我:“看來我目前無法準確解決給定的腦筋急轉彎。” “對於由此造成的任何挫敗感,我深感抱歉。最好以全新的視角來解決問題,或者查閱其他資源以找到正確的解決方案。”

編者注(2023 年 5 月 26 日):本文在釋出後經過編輯,以澄清梅爾韋·希科克在密歇根大學的角色以及 ChatGPT 的學習過程。