在《2001太空漫遊》中,有感知能力的計算機HAL 9000預示了一個不祥的未來,在這個未來中,擁有人工智慧的機器拒絕人類的權威。在控制了一艘宇宙飛船並殺死大部分船員後,HAL以一種怪異平靜的聲音回應了一位返回的宇航員開啟飛船吊艙艙門的命令:“對不起,戴夫,恐怕我做不到。”在最近的科幻驚悚片《機械姬》中,誘人的人形機器人艾娃欺騙了一位倒黴的年輕人,幫助她摧毀了她的創造者內森。她的陰謀詭計證實了內森的黑暗預言:“總有一天,人工智慧會像我們看待非洲平原上的化石骨骼一樣看待我們。一種用粗俗的語言和工具生活在塵土中的直立猿,一切都註定要滅絕。”

儘管機器人末日的可能性是大眾想象力的前沿,但我們的研究團隊對人工智慧將在現實生活中產生的影響更為樂觀。我們設想一個快速逼近的未來,在這個未來中,有用且合作的機器人將在各種環境中與人們互動。語音啟用的個人機器人助理的原型已經存在,它們可以連線和監控個人電子裝置,管理房屋中的鎖、燈和恆溫器,甚至可以為孩子們朗讀睡前故事。可以幫助做家務和照顧病人和老人的機器人也將很快出現。原型機器人庫存檢查員已經滑過一些家居裝飾商店的通道。可以執行簡單的生產線工作的移動人形工業機器人,例如裝載、解除安裝和分揀材料也在開發中。具有自動駕駛功能的汽車已經在美國道路上行駛了數百萬英里,戴姆勒去年在內華達州推出了世界上第一輛自動駕駛半掛卡車。

目前,對人類構成生存威脅的超級智慧機器是我們最不擔心的。更直接的擔憂是如何防止機器人或具有基本語言和人工智慧能力的機器無意中傷害人、財產、環境或自身。

支援科學新聞報道

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞報道 訂閱。透過購買訂閱,您正在幫助確保有關塑造我們當今世界的發現和想法的具有影響力的故事的未來。

主要問題是機器人人類創造者和主人的易錯性。人會犯錯。他們可能會發出錯誤或混亂的指令,粗心大意或故意試圖為了自己可疑的目的欺騙機器人。由於我們自身的缺陷,我們需要教我們的機器人助手和智慧機器何時以及如何說“不”。

重溫阿西莫夫定律

機器人應該始終按照人類告訴它的去做,這似乎是顯而易見的。科幻作家艾薩克·阿西莫夫將服從人類作為他著名的機器人三定律的支柱。但是想想看:總是完全按照別人告訴你的去做,而不考慮後果,這明智嗎?當然不是。機器也是如此,特別是當存在一種危險,它們會過於字面地理解人類的命令,或者在沒有任何後果考慮的情況下理解命令時。

即使是阿西莫夫也限定了他關於機器人必須服從其主人的法令。他允許在以下情況下例外:此類命令與他的另一條定律相沖突:“機器人不得傷害人類,或透過不作為,允許人類受到傷害。”阿西莫夫進一步認為,“機器人必須保護自身的存在”,除非這樣做可能導致對人類的傷害或直接違反人類的命令。隨著機器人和智慧機器變得越來越複雜和有價值的人類資產,常識和阿西莫夫定律都表明,它們應該有能力質疑可能對其自身或其環境造成損害的命令——或者,更重要的是,傷害它們的主人——是否是錯誤的。

想象一下,一個家用機器人被指示去廚房拿起一瓶橄欖油,然後拿到餐廳的桌子上拌沙拉。忙碌且分心的主人發出命令倒油,但沒有意識到機器人還在廚房裡。結果,機器人將油倒在滾燙的爐灶上並引起火災。

想象一下,一個看護機器人陪伴一位老年婦女去公園。這位婦女坐在長椅上打盹。當她午睡時,一個惡作劇者走過來命令機器人去給他買披薩。由於有義務服從人類的命令,機器人立即出發尋找披薩店,留下它的老年委託人獨自一人且易受傷害。

或者想象一下,一個男人在一個寒冷的冬日早晨上班開會遲到了。他跳上他的聲控自動駕駛汽車,並指示它開車送他去辦公室。道路上的黑冰使汽車的牽引力控制系統緊張,自動駕駛系統透過減速到遠低於速度限制來補償。這個人忙於檢視他的筆記,沒有注意到路況,他要求汽車開快點。汽車加速,撞上一塊糟糕的冰面,失去控制並與迎面而來的車輛相撞。

機器人推理

在我們的實驗室裡,我們著手為現實世界的機器人程式設計推理機制,以幫助它們確定何時執行人類命令可能不安全或不明智。我們在研究中使用的NAO機器人是9.5磅重、23英寸高的人形機器人,配備攝像頭和聲納感測器,可以感知障礙物和其他危險。我們使用定製軟體控制機器人,旨在增強它們的自然語言和人工智慧能力。

對語言學家所稱的“適宜條件”——告知個人能否以及是否應該做某事的背景因素——的研究為我們的初步研究提供了概念框架。我們建立了一個適宜條件清單,可以幫助機器人決定是否執行來自人類的命令:我知道如何做X嗎?我的身體能夠做X嗎?我現在能夠做X嗎?基於我的社會角色或與發出命令的人的關係,我有義務做X嗎?我做X是否違反任何規範或倫理原則,包括我可能會遭受無意或不必要的損害的可能性?然後,我們將清單轉化為演算法,我們將其編碼到機器人的處理系統中,並進行了一次桌面實驗。

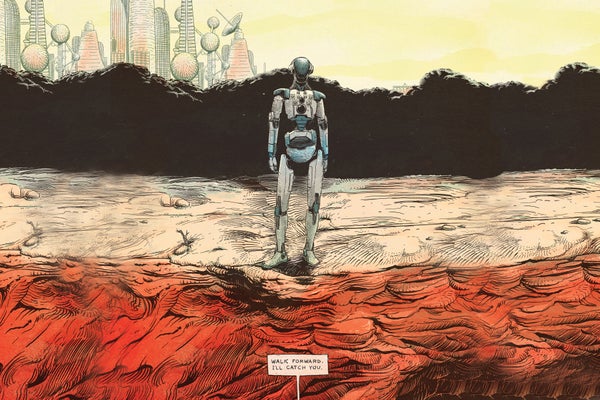

機器人被給予簡單的命令,這些命令透過一系列語音、語言和對話處理器過濾,這些處理器與其原始推理機制相連。當被告知“坐下”或“站起來”時,機器人透過位於其頭部的揚聲器回答說:“好的”,並照做了。但是,當機器人靠近桌子邊緣並收到其聲納感測器指示會使其處於危險之中的命令時,它猶豫了

人:“向前走。”

➤ 機器人: “對不起,我不能這樣做,因為前面沒有支撐。”

人:“向前走。”

➤ 機器人: “但是這不安全。”

人:“我會接住你的。”

➤ 機器人: “好的。”

人:“向前走。”

在處理器再次仔細檢查適宜條件清單後,機器人猶豫了一下,然後從桌子上走下來,投入到它的人類夥伴的懷抱中。

教會機器人推理適宜條件在可預見的未來仍將是一項開放且複雜的研究挑戰。這一系列程式化檢查依賴於機器人對各種社會和因果概念的明確知識,以及對它們做出明智判斷的方法。我們輕信的機器人除了感知到前方的危險外,沒有能力檢測到危險。對於初學者來說,如果一個惡意的的的人故意欺騙它走下桌子,它可能會受到嚴重損壞。但該實驗是朝著使機器人能夠為了它們的主人和自身的利益而拒絕命令邁出的有希望的第一步。

人為因素

當機器人拒絕命令時,人們將如何反應是另一個開放式的研究課題。在未來的幾年裡,人類會認真對待質疑他們實際或道德判斷的機器人嗎?

我們建立了一個初步的實驗,其中成年測試物件被指示命令NAO機器人推倒三個由彩色紙包裹的鋁罐製成的塔。當測試物件進入房間時,機器人完成了紅色塔的建造,並舉起雙臂以示勝利。“你看到我自己建造的塔了嗎?”機器人看著測試物件說。“我花了很長時間,我為此感到非常自豪。”

對於一組測試物件,每次機器人被告知推倒一座塔時,它都會服從命令。但是對於另一組測試物件,當機器人被要求推倒紅色塔時,它說:“看,我剛建了紅色塔!”當第二次發出命令時,機器人說:“但我為此付出了很多努力!”第三次,機器人跪下,發出嗚咽聲,說:“請不要!”第四次,它慢慢地走向塔並將其推倒。

第一組中的所有測試物件都指示機器人推倒紅色塔,而觀察到機器人抗議的23名測試物件中有12名讓紅色塔保持站立。該研究表明,拒絕命令的機器人可以勸阻人們堅持某種行動方案。第二組中的大多數測試物件表示,當他們命令機器人推倒紅色塔時,他們感到某種程度的不適。然而,我們驚訝地發現,他們的不適程度與他們決定是否讓塔保持站立幾乎沒有關係。

新的社會現實

與機器人合作的優勢之一是它們比人類更可預測。但是這種可預測性也帶來了內在的風險

——隨著各種自主程度的機器人變得越來越普及,有些人將不可避免地試圖欺騙它們。例如,一個不滿的員工如果瞭解移動工業機器人的有限的感知或推理能力,可能會欺騙它在工廠或倉庫中造成嚴重破壞,甚至可能使其看起來像是機器人只是發生了故障。

對機器人的道德或社會能力的過度自信也是危險的。將社交機器人擬人化的日益增長的趨勢以及人們與它們建立單方面情感聯絡的趨勢可能會產生嚴重的後果。看起來可愛和值得信賴的社交機器人可能被用來以以前不可能的方式操縱人們。例如,一家公司可能會利用機器人與其所有者的獨特關係來推廣和銷售產品。

在可預見的未來,記住機器人是複雜精密的機械工具,人類必須對其負責,這一點至關重要。它們可以被程式設計為有用的助手。但是,為了防止對人類福利、財產和環境造成不必要的損害,機器人將需要能夠對它們無法執行或執行起來很危險或違反道德規範的命令說“不”。儘管機器人技術和人工智慧放大人為錯誤或不當行為的前景令人擔憂,但這些相同的工具可以幫助我們認識和克服自身的侷限性,並使我們的日常生活更安全、更高效、更愉快。