一個小孩可以看到眼前的任何東西,並描述他們所看到的——但對於人工智慧系統來說,這是一項艱鉅的任務。這是因為它結合了兩項獨立的技能:識別物體的能力以及生成描述場景的句子的能力。多倫多大學和蒙特利爾大學的科學家們開發出軟體,該軟體以腦細胞網路為模型,他們聲稱該軟體可以拍攝任何影像並生成標題,並且在大多數情況下都能正確識別。

他們的方法建立在早期涉及自然語言處理的工作基礎上——自然語言處理是指將語音或文字從一種語言轉換為另一種語言的能力,或者更廣泛地說,是從單詞和句子中提取含義的能力。“這既是影像資訊與自然語言的結合,”多倫多大學的計算機科學家理查德·澤梅爾說。“這就是這裡的新穎之處——影像和文字的結合。我們認為這是一個翻譯問題,”他指出。“當您嘗試將一個句子從英語翻譯成法語時,您必須首先理解英語句子的含義,然後將其轉換為法語。在這裡,您需要影像的含義,內容;然後您可以將其翻譯成文字。”

但是,軟體模型如何“知道”影像中有什麼呢?在系統可以處理不熟悉的圖片之前,它需要在一個龐大的資料集上進行訓練——實際上是三個不同的資料集,其中包含超過 120,000 張已經新增標題的影像。該模型還需要了解在正常的英語句子中,哪些詞可能與其他詞一起出現。例如,一個導致模型生成單詞“boat”(船)的影像,很可能也會使用單詞“water”(水),因為這些詞通常一起出現。此外,它對影像中什麼重要也有一定的概念。澤梅爾指出,例如,如果影像中有人,模型往往會在標題中提到這一點。

支援科學新聞報道

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞報道 訂閱。透過購買訂閱,您正在幫助確保有關當今塑造我們世界的發現和思想的具有影響力的故事的未來。

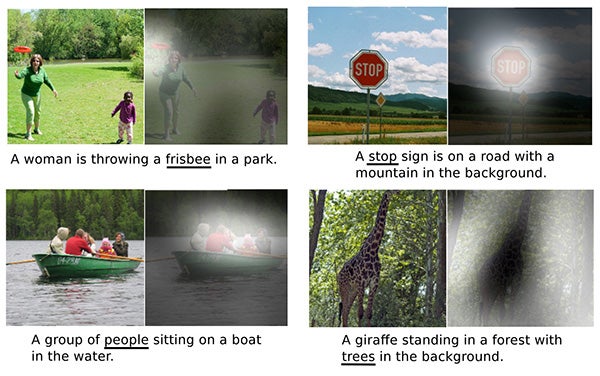

通常,結果是完全正確的。對於一張影像,它生成的標題是“路上的停車標誌,背景是山”——正如影像顯示的那樣;對於“一位女士正在公園裡扔飛盤”和“一隻長頸鹿站在背景有樹木的森林中”的描述也很準確。但偶爾也會出錯。當一張影像包含兩隻彼此靠近但遠離相機的長頸鹿時,它將它們識別為“一隻大型白色鳥”。而一個蔬菜攤後面的小販得到的標題是“一位女士正坐在放著大披薩的桌子旁”。有時,看起來相似的物體只是被誤認為彼此——例如,一個用錫箔紙包裹的三明治可能會被誤認為是一部手機(特別是當有人把它放在臉附近時)。澤梅爾說,在他們的測試中,該模型生成的標題“可以被誤認為是人類的標題”的機率約為 70%。

澤梅爾說,一個潛在的應用可能是作為視力障礙人士的輔助工具。盲人可能會拍攝他們面前的任何東西的照片,並要求系統生成一個描述場景的句子。它還可以幫助完成原本費力的影像標記任務。(媒體機構可能想要立即找到所有兒童玩冰球或工廠組裝汽車的檔案影像——如果硬碟驅動器上的數千張影像尚未標記,這將是一項艱鉅的任務。)

圖片來源:Microsoft COCO/Kelvin Xu 等人

該模型在思考嗎?“該模型正在做的事情與大腦正在做的事情之間存在類比,”澤梅爾說,特別是在表示外部世界以及將“注意力”集中在場景的特定部分方面。“它正在朝著我們想要實現的目標前進,即讓機器能夠以一種反映理解的方式構建我們日常世界的表示。”

澤梅爾和他的同事們將在七月舉行的國際機器學習會議上發表一篇關於這項工作的論文“展示、關注和講述:基於視覺注意力的神經影像字幕生成”。