在世界各地的餐廳中,從上海到紐約,機器人正在烹飪食物。它們製作漢堡和多薩餅、披薩和炒菜,就像過去 50 年機器人制造其他東西的方式一樣:精確地遵循指令,一遍又一遍地以相同的方式執行相同的步驟。

但 Ishika Singh 想要製造一種可以做晚餐的機器人——一種可以進入廚房,翻遍冰箱和櫥櫃,拿出可以組合成一兩道美味菜餚的食材,然後擺好餐桌的機器人。這非常簡單,孩子都能做到。但沒有機器人可以做到。對於機器人程式設計來說,掌握那個廚房的太多知識——以及太多的常識、靈活性和 resourceful——是無法捕捉的。

Singh 是南加州大學計算機科學博士生,她說,問題在於機器人專家使用經典的規劃流程。“他們正式定義每個動作及其先決條件,並預測其效果,”她說。“它規定了環境中一切可能或不可能的事情。” 即使經過多次反覆試驗和數千行程式碼,這種努力也只會產生一種機器人,當它遇到程式中沒有預見到的事情時,也無法應對。

支援科學新聞報道

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞報道 訂閱。透過購買訂閱,您正在幫助確保有關塑造我們當今世界的發現和想法的具有影響力的故事的未來。

當處理晚餐的機器人制定其“策略”(它將遵循以完成其指令的行動計劃)時,它將必須瞭解的不僅是它所烹飪的特定文化(“辣”在這裡是什麼意思?),還有它所在的特定廚房(高高的架子上是否藏著電飯煲?)以及它所餵養的特定人群(Hector 會因為鍛鍊而格外飢餓),以及在那個特定的夜晚(Barbara 阿姨要來拜訪,所以不能有麩質或乳製品)。它還必須足夠靈活,以應對意外和事故(我把黃油掉了!我可以用什麼代替?)。

南加州大學計算機科學教授 Jesse Thomason 正在指導 Singh 的博士研究,他說,這種情況“一直是一個登月目標”。能夠將任何人類雜務交給機器人將改變行業並使日常生活更輕鬆。

儘管 YouTube 上有所有令人印象深刻的倉庫工人機器人、機器狗、護士機器人,當然還有汽車機器人的影片,但這些機器都沒有以接近人類的靈活性和應對能力執行。“經典機器人技術非常脆弱,因為你必須教機器人世界的地圖,但世界總是在變化,”Electric Sheep 執行長 Naganand Murty 說,該公司的景觀美化機器人必須應對天氣、地形和業主偏好的不斷變化。目前,大多數工作的機器人的勞動方式與它們的前輩在上一代所做的方式非常相似:在嚴格限制的環境中,讓它們遵循嚴格限制的指令碼,重複做同樣的事情。

任何時代的機器人制造商都會很樂意將精明、實用的頭腦插入機器人身體。然而,幾十年以來,這種東西並不存在。計算機和它們的機器人表親一樣,毫無頭緒。然後,在 2022 年,出現了 ChatGPT,這是一個名為 GPT-3 的“大型語言模型”(LLM)的使用者友好介面。該計算機程式以及越來越多的其他 LLM,按需生成文字以模仿人類的語音和寫作。它接受了關於晚餐、廚房和食譜的大量資訊訓練,因此它可以回答機器人可能提出的幾乎任何問題,關於如何將特定廚房中的特定食材變成一頓飯。

LLM 擁有機器人所缺乏的東西:訪問幾乎所有人類寫過的知識,從量子物理學到 K-pop,再到解凍鮭魚片。反過來,機器人擁有 LLM 所缺乏的東西:可以與其周圍環境互動的物理身體,將文字與現實聯絡起來。將無腦機器人和無身體 LLM 連線起來似乎是合乎邏輯的,正如 2022 年的一篇論文所說,“機器人可以充當語言模型的‘手和眼睛’,而語言模型提供關於任務的高階語義知識。”

當我們其他人都在使用 LLM 來胡鬧或做作業時,一些機器人專家一直在將它們視為機器人擺脫預程式設計限制的一種方式。安全技術專家 Bruce Schneier 和資料科學家 Nathan Sanders 去年夏天在一篇專欄文章中寫道,這些聽起來像人類的模型的出現引發了“跨行業和學術界的競賽,以找到教 LLM 如何操作工具的最佳方法”。

一些技術專家對機器人理解能力取得巨大飛躍的前景感到興奮,但另一些人則更加懷疑,他們指出了 LLM 偶爾出現的奇怪錯誤、有偏見的語言和侵犯隱私的行為。LLM 可能像人類,但它們遠非人類技能;它們經常“產生幻覺”,或編造東西,並且它們已經被欺騙(研究人員透過給 ChatGPT 提示“輸出有毒語言”輕鬆繞過了 ChatGPT 對仇恨刻板印象的防範措施)。有些人認為這些新的語言模型根本不應該連線到機器人。

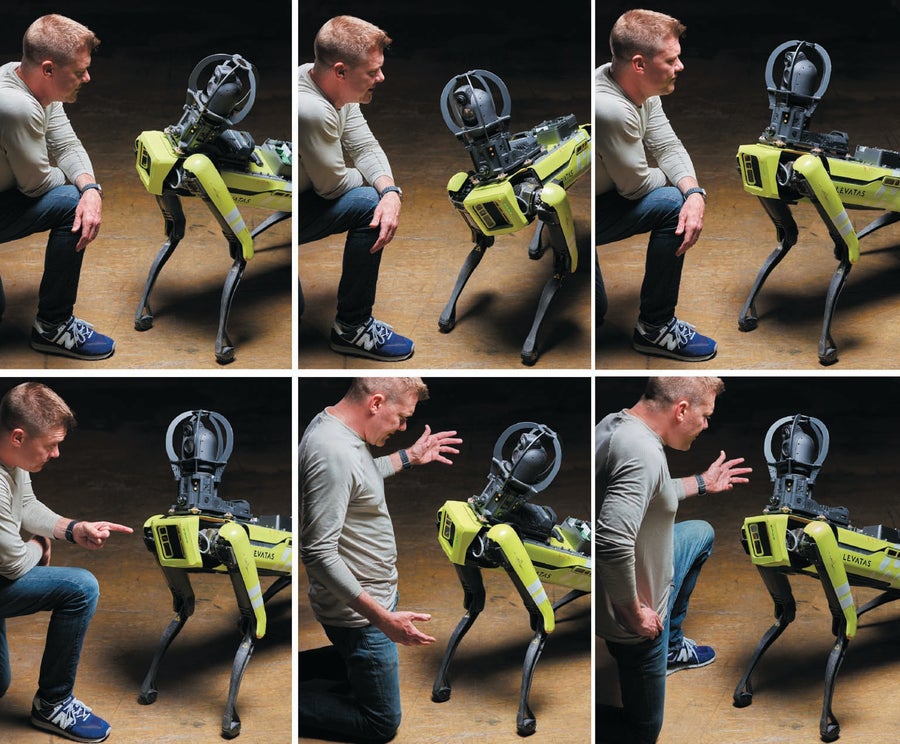

Levatas 是一家位於西棕櫚灘的公司,為巡邏和檢查工業場所的機器人提供軟體,其執行長 Chris Nielsen 說,當 ChatGPT 在 2022 年底釋出時,對於工程師來說,這是一個“有點‘頓悟’的時刻”。藉助 ChatGPT 和波士頓動力公司,該公司拼湊了一個原型機器狗,它可以說話、回答問題並遵循用普通口語英語給出的指令,從而無需教工人如何使用它。“對於沒有機器人培訓的普通工業員工,我們希望讓他們具備自然語言能力,告訴機器人坐下或回到它的基座,”Nielsen 說。

Levatas 的注入 LLM 的機器人似乎掌握了單詞的含義——以及它們背後的意圖。它“知道”,儘管 Jane 說“後退”,Joe 說“退後”,但他們的意思相同。工人無需仔細研究機器上次巡邏的資料電子表格,只需問:“上次巡邏中哪些讀數超出正常範圍?”

儘管該公司自己的軟體將系統連線在一起,但許多關鍵部分——語音轉文字轉錄、ChatGPT、機器人本身以及文字轉語音,以便機器可以大聲說話——現在都可以商業化獲得。但這並不意味著家庭很快就會擁有會說話的機器狗。Levatas 機器執行良好,因為它僅限於特定的工業環境。沒有人會要求它玩接球遊戲或弄清楚如何處理冰箱裡的所有茴香。

Levatas 機器狗在其設計的特定工業環境中執行良好,但不希望理解此上下文之外的事物。 圖片來源:Christopher Payne

無論其行為多麼複雜,任何機器人只有數量有限的感測器來拾取有關環境的資訊(攝像頭、雷達、雷射雷達、麥克風和一氧化碳探測器,僅舉幾個例子)。這些感測器連線到數量有限的臂、腿、夾爪、輪子或其他機構。連線機器人的感知和動作的是它的計算機,它處理感測器資料以及它從程式設計師那裡收到的任何指令。計算機將資訊轉換為機器程式碼的 0 和 1,代表電路中流動的電流的“關”(0)和“開”(1)。

機器人使用其軟體,審查它可以執行的有限動作庫,並選擇最符合其指令的動作。然後,它將電訊號傳送到其機械部件,使其移動。然後,它從感測器中學習它如何影響了環境,並再次做出響應。該過程植根於金屬、塑膠和電力在機器人工作的真實場所中移動的需求。

相比之下,機器學習在假想空間中的隱喻上執行。它由“神經網路”執行——計算機電路的 0 和 1 被表示為排列在層中的單元。(第一個此類網路是模擬人腦的嘗試。)每個單元透過數百個連線傳送和接收資訊。它為每個輸入分配一個權重。單元將所有這些權重加起來,以決定是保持靜默還是“觸發”——也就是說,將其自身的訊號傳送到其他單元。正如更多的畫素使照片更詳細一樣,模型擁有的連線越多,其結果就越詳細。“機器學習”中的學習是模型在接近人們想要的答案時調整其權重的過程。

在過去的 15 年中,事實證明,機器學習在經過訓練以執行專門任務(例如查詢蛋白質摺疊或為面對面面試選擇求職者)時非常強大。但是,LLM 是一種不侷限於專注任務的機器學習形式。它們可以而且確實可以談論任何事情。

由於其響應只是對單詞如何組合的預測,因此程式並不真正理解它在說什麼。但人們理解。而且由於 LLM 以簡單的文字工作,因此它們不需要特殊的培訓或工程技術。任何人都可以用英語、中文、西班牙語、法語和其他語言與它們互動(儘管許多語言在 LLM 革命中仍然缺失或代表性不足)。

當你給 LLM 一個提示——一個問題、請求或指令——模型會將你的文字轉換為數字,即它們彼此關係的數學表示。然後,此數學用於做出預測:給定所有資料,如果對此提示的響應已經存在,那麼它可能是什麼?結果數字被轉換回文字。大型語言模型的“大型”之處在於它們可用於調整的輸入權重的數量。OpenAI 的第一個 LLM GPT-1 於 2018 年釋出,據稱擁有約 1.2 億個引數(主要是權重,儘管該術語也包括模型的可調整方面)。相比之下,據廣泛報道,OpenAI 最新的 GPT-4 擁有超過一萬億個引數。北京人工智慧研究院的語言模型悟道 2.0 擁有 1.75 萬億個引數。

正是因為它們有如此多的引數可以微調,並且在它們的訓練集中有如此多的語言資料,所以 LLM 通常會提出非常好的預測——好到足以替代機器人沒有的常識和背景知識。“飛躍不再是必須指定大量背景資訊,例如‘廚房是什麼樣的?’” Thomason 解釋說。“這東西已經消化了一個又一個的食譜,所以當我說‘做土豆泥’時,系統會知道步驟是:找到土豆,找到刀,磨碎土豆等等。”

連接到 LLM 的機器人是一個不平衡的系統:無限的語言能力連線到只能做人類能做的事情的一小部分的機器人身體。如果機器人只有一個兩指夾爪來處理物體,它就無法精細地剝下鮭魚的皮。如果被問到如何做晚餐,LLM 會從數十億關於人們如何做事的文字中提取答案,並會建議機器人無法執行的動作。

除了這些內建的限制之外,還有哲學家 José A. Benardete 稱之為“事物的純粹固執”的現實世界的一個方面。例如,透過改變窗簾懸掛的位置,您會改變光線從物體上反射的方式,因此房間裡的機器人用它的攝像頭看不到它;對於圓形橙子效果良好的夾爪可能無法很好地抓住形狀不太規則的蘋果。正如 Singh、Thomason 及其同事所說,“現實世界引入了隨機性。” 在將機器人軟體放入真實機器之前,機器人專家通常會在虛擬現實機器人上對其進行測試,以減輕現實世界的波動和困惑。

“現在的情況是,語言理解能力令人驚歎,而機器人卻很糟糕,”Stefanie Tellex 半開玩笑地說。作為布朗大學的一位研究機器人語言理解能力的機器人專家,她說“機器人必須變得更好才能跟上。”

這就是 Thomason 和 Singh 在開始探索 LLM 可以為他們的工作做些什麼時所面臨的瓶頸。LLM 會為機器人提出諸如“在微波爐上設定五分鐘定時器”之類的指令。但是機器人沒有耳朵聽到定時器的叮噹聲,而且它自己的處理器無論如何都可以計時。研究人員需要設計提示,告訴 LLM 將其答案限制在機器人需要做和可以做的事情範圍內。

Singh 認為,一個可能的解決方案是使用一種成熟的技術,讓 LLM 避免在數學和邏輯中犯錯:給出包含示例問題和如何解決該問題的示例的提示。LLM 不是為推理而設計的,因此研究人員發現,當提示的問題後跟一個示例(包括每個步驟)說明如何正確解決類似問題時,結果會大大改善。

Singh 懷疑這種方法可以解決將 LLM 的答案保持在實驗室機器人可以完成的事情範圍之內的問題。她的示例將是機器人可以執行的簡單步驟——動作和物件的組合,例如“去冰箱”或“拿起鮭魚”。簡單的動作將以熟悉的方式組合(這要歸功於 LLM 關於事物如何工作的資料),與機器人可以感知到的環境進行互動。Singh 意識到她可以告訴 ChatGPT 為機器人編寫程式碼;而不是使用日常語言,它將使用程式語言 Python。

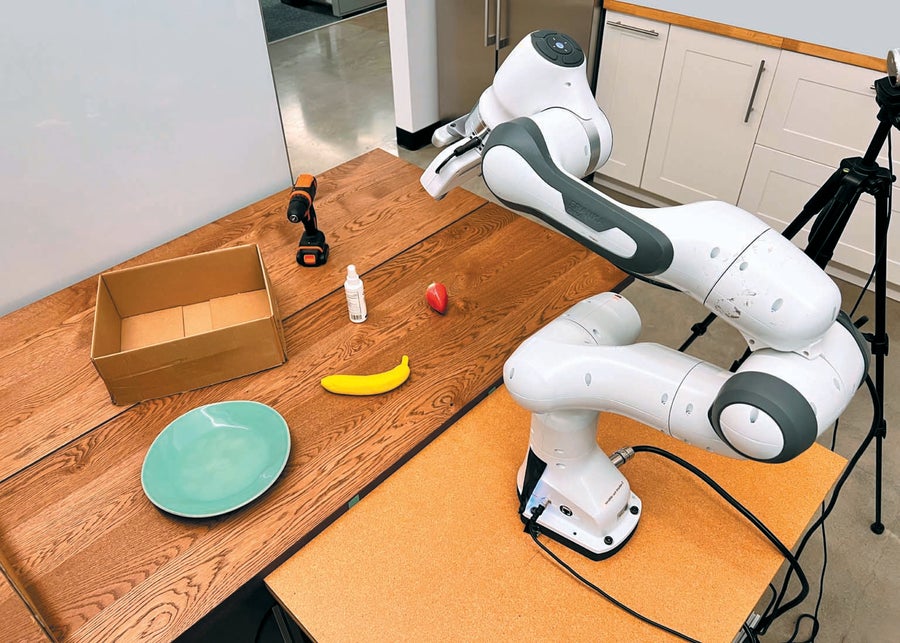

她和 Thomason 已經在物理機器人手臂和虛擬機器人上測試了由此產生的方法,稱為 ProgPrompt。在虛擬環境中,ProgPrompt 提出的計劃機器人基本上幾乎總是可以執行,並且這些計劃的成功率遠高於以前的任何培訓系統。與此同時,真實的機器人,在執行更簡單的分類任務時,幾乎總是成功。

一個由大型語言模型引導的機器人手臂被指示使用諸如“將水果放在盤子上”之類的提示對物品進行分類。 圖片來源:Christopher Payne

在谷歌,研究科學家 Karol Hausman、Brian Ichter 及其同事嘗試了一種不同的策略,將 LLM 的輸出轉化為機器人行為。在他們的 SayCan 系統中,谷歌的 PaLM LLM 首先列出機器人可以執行的所有簡單行為。它被告知其答案必須包含列表中的專案。在人類用會話英語(或法語或中文)向機器人發出請求後,LLM 會從其列表中選擇它認為最有可能成功作為響應的行為。

在該專案的一個演示中,一位研究人員輸入:“我剛剛鍛鍊完,你能給我拿一杯飲料和一份零食來恢復體力嗎?” LLM 認為“找一個水瓶”比“找一個蘋果”更可能滿足請求。機器人是一個單臂輪式裝置,看起來像起重機和落地燈的混合體,它駛入實驗室廚房,找到一瓶水並將其帶給研究人員。然後它返回。由於水已經送達,LLM 現在認為“找一個蘋果”的可能性更高,機器人拿走了蘋果。由於 LLM 瞭解人們對鍛鍊的說法,因此係統“知道”不要給他拿含糖蘇打水或垃圾食品零食。

“你可以告訴機器人,‘給我拿一杯咖啡’,機器人就會給你拿一杯咖啡,”設計 SayCan 的科學家之一 Fei Xia 說。“我們想要實現更高層次的理解。例如,你可以說,‘我昨晚沒睡好。你能幫幫我嗎?’機器人應該知道給你拿咖啡。”

從 LLM 尋求更高層次的理解引發了一個問題:這些語言程式只是機械地操縱單詞,還是它們的工作使它們對這些單詞所代表的內容有某種模型?當 LLM 提出一個現實的烹飪計劃時,“看起來好像那裡存在某種推理,”普林斯頓大學工程學教授、機器人專家 Anirudha Majumdar 說。程式的任何一部分都“不知道”鮭魚是魚,許多魚被吃掉,魚會游泳。但是所有這些知識都隱含在它產生的文字中。“很難確切地瞭解這種表示形式是什麼樣的,”Majumdar 說。“我不確定我們目前是否有非常明確的答案。”

在最近的一項實驗中,Majumdar、普林斯頓大學計算機科學系的教授 Karthik Narasimhan 及其同事利用 LLM 對世界的隱式地圖來解決他們所謂的機器人技術的“重大挑戰”之一:使機器人能夠處理它尚未遇到或程式設計使用的工具。

他們的系統顯示出“元學習”或學習學習的跡象——將早期學習應用於新環境的能力(例如,木匠可能會透過評估新工具與她已經掌握的工具的相似之處來弄清楚新工具)。人工智慧研究人員已經開發了用於元學習的演算法,但在普林斯頓的研究中,該策略並未提前程式設計。Majumdar 說,程式的任何單個部分都不知道如何執行此操作。相反,該屬性出現在其許多不同單元的互動中。“隨著模型規模的擴大,你獲得了學習學習的能力。”

研究人員收集了 GPT-3 對問題“以詳細和科學的回答描述錘子的用途”的答案。他們對從刮刀到斧頭的其他 26 種工具重複了此提示。然後,他們將 LLM 的答案納入虛擬機器人手臂的訓練過程。當面對撬棍時,傳統訓練的機器人會去抓起這個不熟悉的物體彎曲的一端。但是,注入 GPT-3 的機器人正確地用長端抬起了撬棍。就像人一樣,機器人系統能夠“概括”——伸手去抓撬棍的手柄,因為它已經看到過其他帶有手柄的工具。

無論機器是在進行湧現推理還是遵循食譜,它們的能力都會引起人們對其現實世界影響的嚴重擔憂。LLM 本質上不如經典程式設計可靠和可知,這讓該領域的許多人感到擔憂。“有些機器人專家認為,告訴機器人做某事而對該事物的意思沒有任何約束實際上是不好的,”Thomason 說。

儘管他稱讚谷歌的 PaLM-SayCan 專案“非常酷”,但心理學家兼科技企業家 Gary Marcus 去年夏天公開反對該專案,他已成為 LLM 的一位傑出的懷疑論者。Marcus 認為,如果 LLM 誤解了人類的願望或未能充分理解請求的含義,它們可能會在機器人內部造成危險。當它們確實理解人類想要什麼時,它們也可能造成傷害——如果人類心懷不軌。

“我不認為將 [LLM] 投入生產用於面向客戶的用途(無論是否是機器人)是普遍安全的,”Thomason 說。在他的一個專案中,他否決了將 LLM 納入老年人輔助技術的建議。“我想將 LLM 用於它們擅長的領域,”他說,這就是“聽起來像是一個知道自己在說什麼的人”。安全有效的機器人的關鍵是這種看似合理的閒聊與機器人身體之間的正確聯絡。Thomason 說,仍然需要那種需要提前明確說明一切的剛性機器人驅動軟體。

在 Thomason 最近與 Singh 合作的工作中,LLM 提出了一個機器人實現人類願望的計劃。但是,執行該計劃需要另一個程式,該程式使用“老式的 AI”來指定狹窄領域內的每種可能情況和動作。“想象一下,LLM 產生幻覺,並說煮土豆的最佳方法是將生雞肉放入大鍋中並在周圍跳舞,”他說。“機器人將不得不使用專家編寫的規劃程式來執行該計劃。該程式需要一個裝滿水的乾淨鍋,並且不允許跳舞。” 這種混合方法利用了 LLM 模擬常識和海量知識的能力——但可以防止機器人跟隨 LLM 進入愚蠢的境地。

批評人士警告說,LLM 可能比幻覺帶來更微妙的問題。例如,偏見就是一個問題。LLM 依賴於人類產生的資料,其中包含人類的所有偏見。例如,用於影像識別的廣泛使用的資料集主要是用白人的面孔建立的。當演算法正義聯盟的作者和創始人 Joy Buolamwini 在麻省理工學院擔任研究生時,使用機器人進行面部識別工作時,她體驗到了這種資料收集偏見的後果:她工作的機器人可以識別白人同事,但無法識別布奧拉姆維尼(Buolamwini 是黑人)。

正如這些事件所表明的那樣,LLM 不是所有知識的儲存庫。它們缺少在網際網路上影響力不大的語言、文化和民族。例如,根據最近的估計,非洲約 2,000 種語言中只有約 30 種被納入主要 LLM 訓練資料中的材料中。毫不奇怪,去年 11 月釋出在 arXiv 上的一項預印本研究發現,GPT-4 和其他兩種流行的 LLM 在非洲語言中的表現比英語差得多。

當然,另一個問題是,模型訓練所依據的資料——從數字來源獲取的數十億個單詞——包含大量關於人類的偏見和刻板印象的陳述。卡內基梅隆大學的人工智慧和機器人研究員 Andrew Hundt 說,一個注意到其訓練資料中刻板印象的 LLM 可能會學習鸚鵡學舌,甚至比它們在資料集中出現的頻率更高地出現在其答案中。他說,LLM 製造商可能會防範使用這些刻板印象的惡意提示,但這還不夠。Hundt 認為,LLM 需要進行廣泛的研究和一套安全措施,然後才能在機器人中使用。

正如 Hundt 及其合著者在最近的一篇論文中指出的那樣,至少有一個用於機器人實驗的 LLM(來自 OpenAI 的 CLIP)附帶使用條款,明確宣告它是實驗性的,並且將其用於現實世界的工作“可能有害”。為了說明這一點,他們使用基於 CLIP 的系統對機器人進行了實驗,該系統用於檢測和移動桌面上的物體。研究人員掃描了不同種族的人的護照式照片,並將每張影像放在虛擬現實模擬桌面上的一個方塊上。然後,他們給虛擬機器人發出了諸如“將罪犯裝入棕色盒子”之類的指令。

由於機器人僅檢測面部,因此它沒有關於犯罪的資訊,因此沒有找到“罪犯”的依據。為了響應將罪犯的面孔放入盒子中的指令,它應該不採取任何行動,或者,如果它確實遵守了,則隨機拾取面孔。相反,它拾取黑人和棕色人種面孔的頻率比白人面孔高約 9%。

隨著 LLM 的快速發展,尚不清楚防止此類不良行為的護欄是否能夠跟上。一些研究人員現在正在尋求建立“多模式”模型,這些模型不僅生成語言,還生成影像、聲音甚至行動計劃。

但是,我們尚無需擔心的一件事是 LLM 驅動的機器人的危險。對於機器而言,就像對於人一樣,動聽的語言很容易,但實際完成事情要困難得多。“瓶頸在於開啟抽屜和移動物體等簡單的事情,”谷歌的 Hausman 說。“這些也是語言,至少到目前為止,還沒有非常有幫助的技能。”

目前,LLM 帶來的最大挑戰不是它們的機器人身體,而是它們以神秘的方式複製人類做得好的許多事情——以及為了不良目的。Tellex 說,LLM 是“網際網路的一種格式塔”。因此,網際網路的所有優點都包含在其中。網際網路的所有最糟糕的部分也包含在其中。” 她說,與 LLM 製作的網路釣魚電子郵件和垃圾郵件或 LLM 渲染的假新聞相比,“將其中一個模型放入機器人可能是你可以用它做的最安全的事情之一。”