當迪米特里斯·帕帕伊利奧波洛斯第一次要求 ChatGPT 解釋影像中的顏色時,他想到的是“那條裙子”——2015 年在網際網路上引起轟動的臭名昭著的迷惑性光學錯覺照片。帕帕伊利奧波洛斯是威斯康星大學麥迪遜分校計算機工程系的副教授,他研究的是支撐 聊天機器人(如 OpenAI 的 ChatGPT 和谷歌的 Gemini)的人工智慧型別。他很好奇這些 AI 模型會對欺騙人腦的錯覺做出何種反應。

人類視覺系統已經適應將物體感知為具有一致的顏色,以便我們仍然可以在不同的光照條件下識別物品。在我們的眼中,葉子在明媚的中午和橙色的日落中看起來都是綠色的——即使葉子隨著時間的推移反射不同的光波長。這種適應性使我們的大腦擁有了各種巧妙的方式來看見錯誤的顏色,其中許多導致了熟悉的光學錯覺,例如,當被圓柱體陰影遮蔽時,看起來圖案始終如一的棋盤(但並非如此)——或者物體,例如當分層扭曲條紋時,可口可樂罐會錯誤地以其熟悉的顏色出現。

在一系列測試中,帕帕伊利奧波洛斯觀察到 GPT-4V(ChatGPT 的最新版本)似乎會像人一樣被許多相同的視覺欺騙所愚弄。聊天機器人的答案通常與人類的感知相符——不是識別影像中畫素的實際顏色,而是描述一個人可能看到的相同顏色。即使是帕帕伊利奧波洛斯建立的照片也是如此,例如一張藍色濾鏡下的生魚片,仍然看起來是粉紅色的。這張特殊的影像是顏色恆常性錯覺的一個例子,以前從未在網上釋出過,因此不可能包含在任何 AI 聊天機器人的訓練資料中。

支援科學新聞

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞報道 訂閱。透過購買訂閱,您正在幫助確保有關當今塑造我們世界的發現和想法的具有影響力的故事的未來。

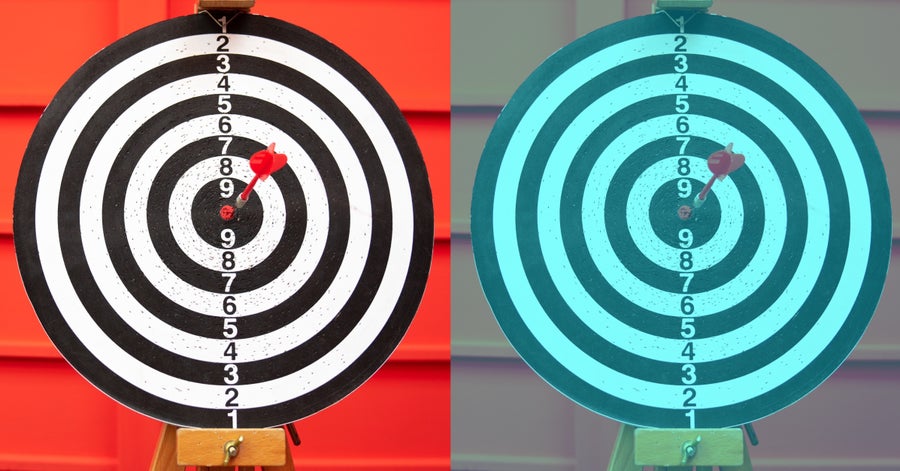

目標物的圖片(左)和顯示顏色恆常性錯覺的藍色濾鏡影像(右)。儘管經過處理的版本中的靶心看起來是紅色的,但實際上,它的畫素具有更大的藍色和綠色值。(藍色濾鏡是使用 Akiyoshi Kitaoka 建立的工具應用的。)

krisanapong detraphiphat/Getty Images(照片);Akiyoshi Kitaoka 的直方圖壓縮(藍色濾鏡)

帕帕伊利奧波洛斯指出,“這不是一項科學研究”,只是一些隨意的實驗。但他說,聊天機器人令人驚訝的類人反應沒有明確的解釋。起初,他想知道 ChatGPT 是否會清理原始影像,以使其處理的資料更加統一。然而,OpenAI 在一封電子郵件中告訴大眾科學,ChatGPT 在 GPT-4V 解釋輸入影像之前,不會微調輸入影像的色溫或其他特徵。在沒有這種直接解釋的情況下,帕帕伊利奧波洛斯說,視覺語言 Transformer 模型有可能已經學會了在上下文中解釋顏色,評估影像中的物體相對於彼此,並相應地評估畫素,這與人腦所做的事情類似。

布萊克·理查茲是麥吉爾大學計算機科學和神經科學副教授,他同意該模型可能像人類一樣在上下文中學習顏色,識別物體並響應該型別物品通常出現的方式。例如,在“那條裙子”的案例中,科學家認為,不同的人根據他們對照亮織物的光源的假設,以兩種不同的方式(金色和白色或藍色和黑色)解釋了顏色。

理查茲說,AI 模型能夠以類似細緻的方式解釋影像,這一事實有助於我們理解人們可能如何發展相同的技能。“它告訴我們,我們自己這樣做的傾向幾乎肯定是簡單接觸資料的結果,”他解釋道。如果一個演算法被輸入大量的訓練資料,開始主觀地解釋顏色,這意味著人類和機器的感知可能是非常一致的——至少在這一個方面是這樣。

然而,正如最近的研究表明,在其他情況下,這些模型的行為完全不像我們——這一事實揭示了人和機器“看”世界方式之間的關鍵差異。一些研究人員發現,新開發的視覺語言 Transformer 模型對錯覺的反應不一致。有時它們的反應與人類相同;在其他情況下,它們提供純粹邏輯和客觀準確的反應。有時它們會用完全胡說八道來回答,這可能是幻覺的結果。

這些研究背後的動機不是為了證明人類和 AI 是相似的。一個根本的區別是,我們的大腦充滿了非線性連線和反饋迴路,這些迴路來回傳遞訊號。正如我們的眼睛和其他感覺系統從外部世界收集資訊一樣,這些迭代網路“幫助我們的大腦填補任何空白”,安大略省約克大學的計算神經科學家 喬爾·齊爾伯伯格說道,他沒有參與光學錯覺研究。儘管已經開發了一些迴圈神經網路來模仿人腦的這一方面,但許多機器學習模型並非旨在具有重複的、雙向的連線。最流行的生成式 Transformer AI 模型依賴於“前饋”的數學函式。這意味著資訊僅在一個方向上透過它們移動:從輸入到輸出。

研究這種 AI 系統對光學錯覺的反應,可以幫助計算機科學家更好地理解這些單向機器學習模型的能力和偏見。它可以幫助 AI 研究人員專注於復發之外的哪些因素與模仿人類反應有關。

一個潛在的因素是模型的大小,根據一個計算機科學家團隊的說法,該團隊評估了四個開源視覺語言模型,並在 2023 年 12 月的會議上展示了其發現。研究人員發現,較大的模型,即那些使用更多權重和變數(決定響應)開發的模型,比小型模型更接近人類對光學錯覺的反應。總體而言,科學家測試的 AI 模型在專注於影像中的錯覺元素方面表現不佳(平均準確率低於 36%),並且平均只有約 16% 的情況下與人類反應一致。然而,該研究還發現,模型在響應某些型別的錯覺時比其他型別的錯覺更接近人類。

例如,要求這些模型評估透視錯覺,產生了最像人類的輸出。在透視錯覺中,影像中大小相等的物體在背景暗示三維深度時,看起來具有不同的大小。模型被要求判斷影像中物體輪廓的相對大小——研究人員還重複了成對和翻轉影像的測試,以檢測模型響應中任何潛在的右側或左側偏差。如果機器人對所有問題的回答都與標準的人類感知相符,研究作者將其視為“類人”。對於一種提示型別,即衡量模型在影像中定位物體的能力,在響應透視錯覺方面,測試的兩個模型高達 75% 具有類人水平。在其他測試和其他模型中,類人反應的比率要低得多。

在 3 月份釋出的一項單獨的預印本研究中,研究人員測試了 GPT-4V 和谷歌的 Gemini-Pro 評估 12 種不同類別的光學錯覺的能力。這些類別包括不可能物體錯覺,它是三維空間中不存在的物體的二維圖形,以及隱藏影像錯覺,其中物體的輪廓包含在影像中,但並不立即明顯。在 12 個類別中的 9 個類別中,與人相比,這些模型在查明錯覺中發生的事情方面表現更差,平均準確率為 59%,而人類受訪者的準確率為 94%。但在三個類別——顏色、角度和大小錯覺——GPT-4V 的表現與人類審閱者相當,甚至略好於人類審閱者。

該研究的作者之一、亞馬遜網路服務公司 AI 實驗室的應用科學家瓦西·艾哈邁德認為,差異在於分析錯覺是否需要定量或定性推理。人類擅長兩者。另一方面,機器學習模型可能不太擅長根據無法輕易衡量的東西做出判斷,艾哈邁德說。AI 系統最擅長解釋的所有三個錯覺類別都涉及可量化的屬性,而不僅僅是主觀感知。

密歇根大學計算機科學教授兼 AI 研究員、2023 年 12 月會議上提出的預印本的高階作者喬伊斯·柴說,為了負責任地部署 AI 系統,我們需要了解它們的漏洞和盲點,以及人類傾向將在何處以及何處不會被複制。“模型與人類保持一致可能是好事也可能是壞事,”她說。在某些情況下,模型減輕人類偏見是可取的。例如,分析放射影像的 AI 醫療診斷工具最好不要容易受到視覺錯誤的影響。

然而,在其他應用中,AI 模仿某些人類偏見可能是有益的。理查茲指出,我們可能希望自動駕駛汽車中使用的 AI 視覺系統與人類錯誤相匹配,以便車輛錯誤更容易預測和理解。“自動駕駛汽車的最大危險之一不是它們會犯錯誤。人類一直在犯駕駛錯誤,”他說。但他擔心自動駕駛汽車的是它們的“奇怪錯誤”,道路上已建立的安全系統尚未準備好處理這些錯誤。

OpenAI 的 GPT-4V 和其他大型機器學習模型通常被描述為黑匣子——提供輸出但沒有解釋的不透明系統——但光學錯覺這種非常人性化的現象可能會讓我們一窺其內部。