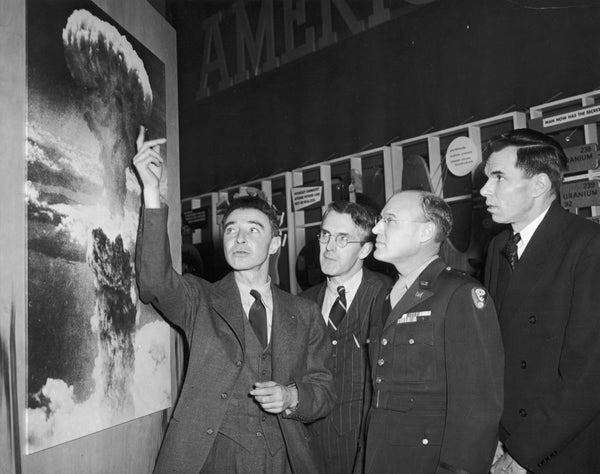

八十一年前,富蘭克林·D·羅斯福總統委任年輕的物理學家 J. 羅伯特·奧本海默在新墨西哥州洛斯阿拉莫斯建立一個秘密實驗室。奧本海默和他的同事們的任務是開發世界上第一批核武器,代號為曼哈頓計劃。不到三年後,他們成功了。1945 年,美國在日本的廣島和長崎市投放了這些武器,造成數十萬人死亡。

奧本海默因此被稱為“原子彈之父”。儘管他對自己在戰時的工作和技術成就感到沾沾自喜,但他後來也開始公開表示需要控制這項危險技術。

但是美國沒有聽取他的警告,地緣政治恐懼反而佔據了上風。美國競相部署威力越來越大的核系統,卻鮮有認識到這些武器將造成的巨大且不成比例的危害。官員們也無視奧本海默關於加強國際合作以監管核技術的呼籲。

支援科學新聞報道

如果您喜歡這篇文章,請考慮支援我們屢獲殊榮的新聞報道,方式是 訂閱。透過購買訂閱,您將有助於確保有關塑造我們今天世界的發現和思想的具有影響力的故事的未來。

奧本海默的例子也為我們今天提供了教訓。我們絕不能在人工智慧上重蹈我們在核武器上犯過的錯誤。

我們仍處於一場承諾中的人工智慧革命的早期階段。科技公司正在競相構建和部署人工智慧驅動的大型語言模型,例如 ChatGPT。監管機構需要跟上步伐。

儘管人工智慧承諾帶來巨大的好處,但它已經暴露了其危害和濫用的潛力。今年早些時候,美國 Surgeon General 釋出了一份關於青少年心理健康危機的報告。報告發現,2021 年,三分之一的少女曾考慮過自殺。資料是明確的:大型科技公司是問題的重要組成部分。人工智慧只會放大這種操縱和剝削。人工智慧的效能依賴於剝削性的勞動實踐,包括國內和國際。龐大而不透明的人工智慧模型以有問題的資料為食,往往會加劇社會中現有的偏見——影響到一切,從刑事判決和警務到醫療保健、貸款、住房和招聘。此外,執行此類能源密集型人工智慧模型的環境影響,給已經因氣候變化的影響而搖搖欲墜的脆弱生態系統帶來了壓力。

人工智慧還可能使潛在的危險技術更容易被流氓分子獲取。去年,研究人員要求一個生成式人工智慧模型設計新的化學武器。它在六小時內設計了 40,000 種潛在的武器。早期版本的 ChatGPT 生成了炸彈製造說明。麻省理工學院的一個課堂練習最近證明了人工智慧如何幫助建立合成病原體,這可能會引發下一次大流行。透過傳播獲取此類危險資訊的途徑,人工智慧有可能成為計算機化的突擊武器或高容量彈匣:一個流氓分子釋放前所未有的毀滅性危害的工具。

然而,競相部署未經測試的人工智慧的不僅是公司和私人行為者。我們也應該警惕政府推動人工智慧軍事化。我們已經擁有一個岌岌可危地建立在相互確保摧毀基礎上的核武器發射系統,在感知到即將到來的襲擊時,世界各國領導人只有幾分鐘的時間來決定是否發射核武器。人工智慧驅動的核武器發射系統自動化可能很快就會取消“人在迴路中”的做法——這是確保有缺陷的計算機智慧不會導致核戰爭的必要保障,而核戰爭已經非常接近多次發生。旨在讓決策者在日益複雜的世界中擁有更大應對能力的軍事自動化競賽可能會導致衝突失控。如果各國競相採用軍事化人工智慧技術,我們都將成為輸家。

正如 20 世紀 40 年代一樣,現在是塑造這項新興且可能危險的技術發展的關鍵視窗期。奧本海預設識到,美國應該甚至與其最深的對抗者合作,以國際上控制核技術的危險一面——同時繼續追求其和平用途。美國譴責這個人及其想法,反而透過開發氫彈以及相關的昂貴且有時離奇的運載系統和大氣層測試,開啟了大規模的冷戰軍備競賽。由此產生的核工業綜合體對最脆弱的群體造成了不成比例的傷害。鈾礦開採和大氣層測試導致包括新墨西哥州居民、馬紹爾群島社群和納瓦霍族成員在內的群體患上癌症。浪費性支出、機會成本以及對邊緣化社群的影響是不可估量的——更不用說隨之而來的無數次險情和核武器擴散了。今天,我們需要國際合作和國內監管,以確保人工智慧安全發展。

國會現在必須採取行動監管科技公司,以確保它們將集體公共利益放在首位。國會應首先透過我的《兒童線上隱私保護法》、我的《演算法正義和線上透明度法案》以及我的禁止人工智慧發射核武器的法案。但這僅僅是開始。在白宮的《人工智慧權利法案藍圖》的指導下,國會需要透過廣泛的法規,以阻止這種魯莽地競相構建和部署不安全的人工智慧的行為。關於如何以及在何處使用人工智慧的決策不能僅由科技公司來決定。它們必須以最容易受到人工智慧剝削和傷害的社群為中心來制定。我們必須對與盟友和對手合作持開放態度,以避免人工智慧在軍事和民用方面的濫用。

在核時代開始時,美國沒有聽取奧本海默關於軍備競賽危險的警告,而是鳴響了發令槍。八十年後,我們有道義責任和明確的利益不重蹈覆轍。

這是一篇觀點和分析文章,作者或作者表達的觀點不一定代表《大眾科學》的觀點。