殺人機器即將到來。無需人類監督即可瞄準和摧毀目標的機器人武器,勢必會引發一場堪比火藥或原子彈發明的戰爭革命。這種前景對平民構成了可怕的威脅,並可能導致人工智慧失控的一些最黯淡的局面。 迫切需要禁止殺人機器人,類似於禁止化學和生物武器。但一些主要的軍事強國反對這樣做。

機器人絕非技術恐懼症的幻想。 例如,2017年7月,俄羅斯卡拉什尼科夫集團宣佈,它已開始研製配備攝像頭的7.62毫米機槍,該機槍使用神經網路來做出“射擊/不射擊”的決定。 包括無人機、艦船和坦克在內的整整一代自主控制武器,正朝著不同程度的自主執行發展。 美國似乎在自主系統研發方面處於領先地位,從2016年到2020年,計劃投資180億美元。 但其他擁有強大軍工業的國家也在進行自己的投資。

軍事規劃人員認為,“致命自主武器系統”——一個更委婉的術語——理論上可以為戰爭帶來超然的精確性。 這種自動裝置可以減少對軍隊的需求,並透過讓機器自行戰鬥來減少傷亡。 然而,演算法控制可能會演變成“失控”。 現有的人工智慧無法推斷他人的意圖,也無法在混亂的戰爭中透過概括過去的經驗來做出關鍵決策。 在可預見的未來任務中,人工智慧是否應該取代美國大兵,這應該受到質疑,因為人工智慧無法解讀行為的細微之處來區分平民和戰鬥人員,或友軍和敵軍。 任何型別的殺人機器人都會是訓練有素的刺客,就像《終結者》中的阿諾德·施瓦辛格一樣。 此外,戰鬥結束後,當機器進行殺戮時,誰將承擔責任? 機器人? 它的主人? 它的製造者?

支援科學新聞事業

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞事業 訂閱。 透過購買訂閱,您正在幫助確保有關當今塑造我們世界的發現和想法的具有影響力的故事的未來。

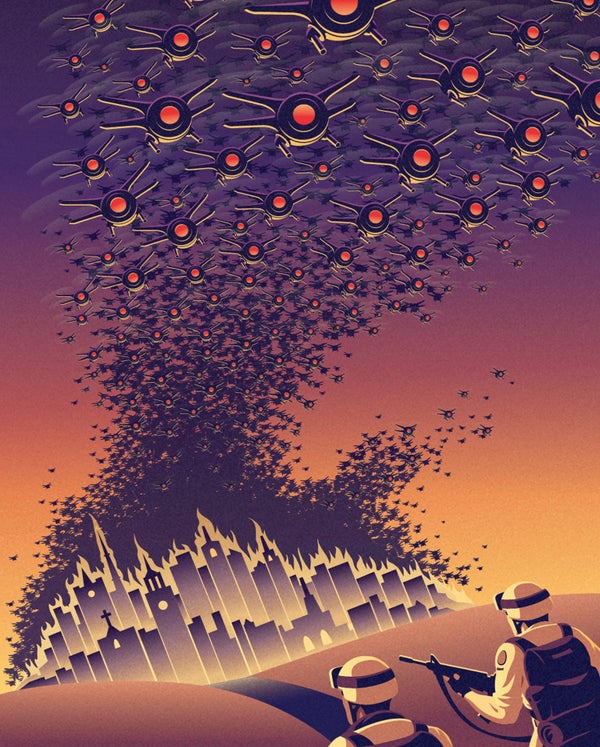

考慮到所有這些缺點,使用近期技術製造的完全自主機器人可能會對專業知識或財政資源匱乏的小國或恐怖分子構成新的威脅。 成群結隊的小型武器化無人機,甚至可能是使用3D列印機制造的,可能會在人口稠密地區造成嚴重破壞。 原型機已經在測試中:美國國防部在2016年演示了超過100架微型無人機的非武器化蜂群。 加州大學伯克利分校的人工智慧研究領域的傑出人物斯圖爾特·羅素認為,僅僅一個人部署的“殺傷人員微型機器人”就可能殺死數千人,並構成潛在的大規模殺傷性武器。

自2013年以來,《聯合國特定常規武器公約》(CCW)一直在討論如何處理致命自主武器系統,該公約 регулирует 燃燒裝置、致盲雷射和其他被認為危害過大的武器。 由於美國、俄羅斯和少數其他國家的反對,討論尚未進入起草正式禁令語言的階段。 例如,美國辯稱,其政策已經規定軍事人員保留對自主武器的控制權,並且過早的監管可能會抑制至關重要的人工智慧研究。

禁令不必過於嚴格。 “停止殺人機器人運動”是一個由來自50個國家的89個非政府組織組成的聯盟,該聯盟一直呼籲禁止這種武器,它強調禁令將僅限於進攻性武器,而不擴充套件到反導和其他自動發射以應對來襲彈頭的防禦系統。

當前的僵局促使該運動考慮爭取至少一些國家在《特定常規武器公約》提供的論壇之外同意禁令,這是以前使用過的一種選擇,以啟動禁止地雷和集束彈藥的國際協議。 搶先禁止自主殺人機器,並制定明確的合規要求,將使這項技術蒙上汙名,並有助於將殺人機器人排除在軍事武庫之外。

自從首次在7月於斯德哥爾摩舉行的國際人工智慧聯合會議上提出以來,已有244個組織和3,187名個人簽署了一項承諾書,承諾“既不參與也不支援致命自主武器的開發、製造、貿易或使用”。 做出這樣承諾的理由是,禁止殺人機器人的法律尚未透過。 如果沒有這樣的法律框架,演算法可能很快就會做出奪走人類生命的致命決定。