研究人員正在濫用 ChatGPT 和其他人工智慧聊天機器人來撰寫科學文獻。至少,這是某些科學家提出的新擔憂,他們指出,已發表論文中出現的可疑 AI 隱語急劇增加。

其中一些跡象——例如最近發表在愛思唯爾出版的期刊Surfaces and Interfaces上的一篇論文中無意中包含的“當然,這是您主題的可能介紹”——是相當明顯的證據,表明科學家使用了被稱為大型語言模型 (LLM) 的 AI 聊天機器人。但科學誠信顧問伊麗莎白·比克說,“這可能只是冰山一角”。(愛思唯爾的一位代表告訴大眾科學,該出版商對這種情況感到遺憾,並且正在調查這種情況是如何“溜過”稿件評估過程的。)在大多數其他情況下,AI 的參與並不那麼明確,而且自動 AI 文字檢測器是分析論文的不可靠的工具。

然而,來自多個領域的研究人員已經確定了一些關鍵詞和短語(例如“複雜且多方面”),這些詞語和短語在 AI 生成的句子中比在典型的人類寫作中更頻繁地出現。“當你長期關注這些東西時,你就會對這種風格有所感覺,”倫敦大學學院的圖書管理員和研究員安德魯·格雷說。

關於支援科學新聞報道

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞報道 訂閱。透過購買訂閱,您正在幫助確保有關塑造我們當今世界的發現和想法的具有影響力的故事的未來。

LLM 旨在生成文字——但它們產生的內容可能在事實上準確,也可能不準確。“問題在於這些工具還不夠好,無法信任,”比克說。它們屈服於計算機科學家所謂的幻覺:簡而言之,它們會編造東西。“具體來說,對於科學論文,”比克指出,AI“將生成不存在的引文參考文獻。” 因此,如果科學家對 LLM 過度信任,研究作者就有可能將 AI 編造的缺陷插入到他們的工作中,從而在已經混亂的科學出版現實中混入更多潛在的錯誤。

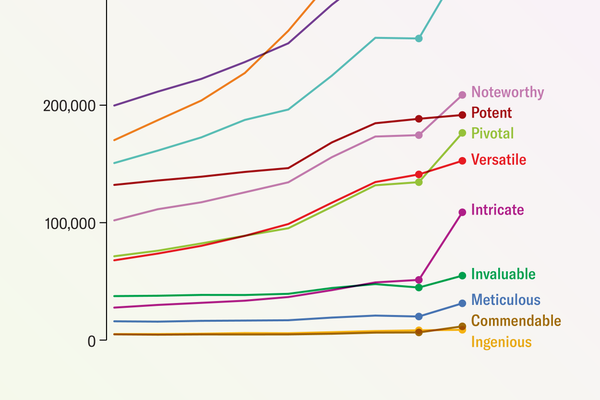

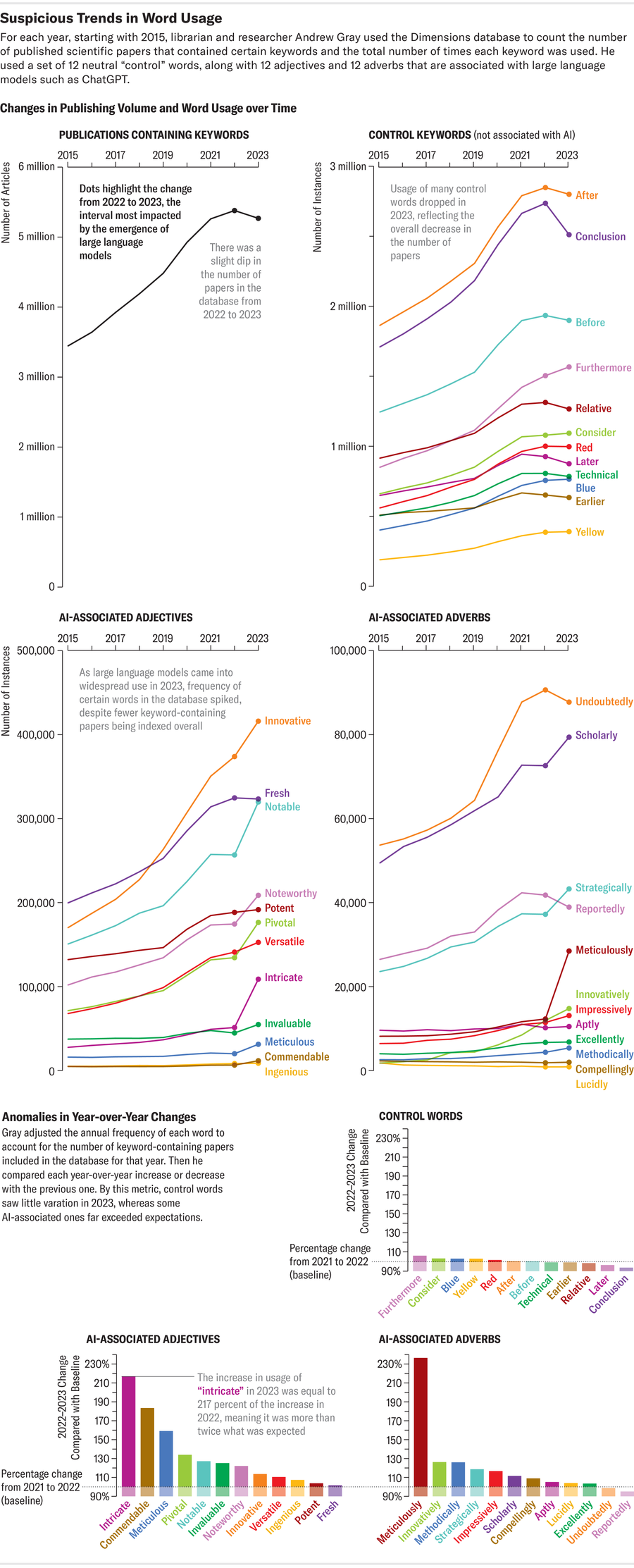

格雷最近使用 Dimensions(一個數據分析平臺,其開發者表示該平臺跟蹤超過 1.4 億篇全球論文)在科學論文中搜索 AI 流行語。他搜尋了聊天機器人過度使用的詞語,例如“錯綜複雜”、“細緻”和“值得稱讚”。他說,這些指示詞比任何笨拙的作者可能複製到論文中的“洩露”AI 短語更能讓人瞭解問題的規模。根據格雷的分析(該分析已在預印本伺服器 arXiv.org 上釋出,但尚未經過同行評審),至少有 60,000 篇論文(略多於去年全球發表的所有科學文章的 1%)可能使用了 LLM。其他專門關注科學子領域的研究表明,對 LLM 的依賴程度更高。其中一項調查發現,高達 17.5% 的最新計算機科學論文表現出 AI 寫作的跡象。

阿曼達·蒙塔內斯;來源:安德魯·格雷

大眾科學自身使用 Dimensions 和其他幾個科學出版物資料庫(包括 Google Scholar、Scopus、PubMed、OpenAlex 和 Internet Archive Scholar)進行的搜尋也支援了這些發現。這項搜尋旨在尋找可以表明 LLM 參與學術論文文字製作的跡象——透過 ChatGPT 和其他 AI 模型通常附加的短語(例如“截至我上次知識更新”)的流行程度來衡量。2020 年,這個短語在調查中使用的四個主要論文分析平臺跟蹤的結果中僅出現一次。但在 2022 年,它出現了 136 次。不過,這種方法存在一些侷限性:它無法過濾掉可能代表 AI 模型自身研究而不是 AI 生成內容的論文。而且這些資料庫包含的材料超出了科學期刊中經過同行評審的文章的範圍。

與格雷的方法類似,這項搜尋還發現了可能指向 LLM 的更微妙的痕跡:它查看了在科學文獻中發現的 ChatGPT 首選的常用短語或詞語的次數,並跟蹤了它們在 OpenAI 的聊天機器人於 2022 年 11 月釋出之前的幾年(追溯到 2020 年)的流行程度是否發生了顯著變化。研究結果表明,科學寫作的詞彙發生了一些變化——這種發展可能是由日益普及的聊天機器人的寫作習慣引起的。“有一些證據表明,隨著語言的正常發展,某些詞語會隨著時間的推移而穩步變化,”格雷說。“但這裡有一個問題,即其中有多少是語言的長期自然變化,又有多少是不同的東西。”

ChatGPT 的症狀

為了尋找 AI 可能參與論文製作或編輯的跡象,大眾科學的搜尋深入研究了“delve”這個詞——正如一些非正式的 AI 製作文字監控者所指出的那樣,該詞在學術界的使用量異常激增。對其在 PubMed 目錄中包含的約 3700 萬篇生命科學和生物醫學引文和論文摘要中的使用情況進行分析,突顯了該詞的流行程度。“delve”一詞的使用量從 2020 年的 349 次增加到 2023 年的 2,847 次,到 2024 年迄今為止已出現 2,630 次——增加了 654%。在涵蓋更廣泛科學領域的 Scopus 資料庫和 Dimensions 資料中,也看到了類似但不太明顯的增長。

根據大眾科學的分析,這些監控者標記為 AI 生成的流行語的其他術語也出現了類似的增長:“commendable”一詞在 Scopus 跟蹤的論文中出現了 240 次,在 Dimensions 跟蹤的論文中出現了 10,977 次(2020 年)。這些數字在 2023 年分別飆升至 829 次(增加 245%)和 20,536 次(增加 87%)。而對於那些想要進行“細緻”研究的人來說,也許具有諷刺意味的是,“meticulous”這個詞在 2020 年至 2023 年間在 Scopus 上的使用量翻了一番。

不僅僅是文字

在一個學術界人士奉行“不發表就滅亡”的座右銘的世界裡,有些人使用聊天機器人來節省時間或加強他們在英語方面的能力,這並不令人意外,因為在科學領域,英語通常是發表論文的必要條件。但是,將 AI 技術用作語法或句法助手可能會成為在科學過程的其他部分誤用它的滑坡。有人擔心,與 LLM 合著者一起撰寫論文可能會導致關鍵人物完全由 AI 生成,或者導致同行評審外包給自動化評估人員。

這些並非純粹是假設的場景。AI 確實已被用於製作科學圖表和插圖,這些圖表和插圖經常被包含在學術論文中——包括一個引人注目的離奇地被賦予了超常生殖器的齧齒動物——甚至取代實驗中的人類參與者。根據一項關於 2023 年和 2024 年在 AI 會議上提交研究成果的科學家收到的反饋語言的預印本研究,AI 聊天機器人的使用可能已經滲透到同行評審過程本身。如果 AI 生成的判斷與 AI 文字一起悄然進入學術論文,這讓包括英國非營利組織出版倫理委員會理事會成員馬特·霍奇金森在內的專家感到擔憂,該委員會旨在促進符合道德規範的學術研究實踐。聊天機器人“不擅長進行分析,”他說,“而這才是真正的危險所在。”

本文的一個版本題為“聊天機器人入侵”,經過改編後收錄在 2024 年 7 月/8 月號的大眾科學雜誌中。