2014年,SpaceX 執行長埃隆·馬斯克發推文說:“值得閱讀博斯特羅姆的《超級智慧》。我們需要對人工智慧超級小心。可能比核武器更危險。” 同年,劍橋大學宇宙學家斯蒂芬·霍金告訴 BBC:“全面人工智慧的發展可能意味著人類的終結。” 微軟聯合創始人比爾·蓋茨也警告說:“我屬於擔心超級智慧陣營。”

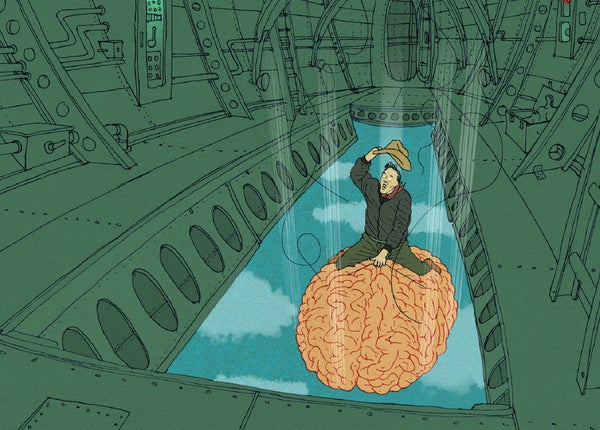

計算機科學家埃利澤·尤德科夫斯基在 2008 年出版的《全球災難性風險》一書中概述了人工智慧末日可能如何展開:“人工智慧從變形蟲跨越到鄉村白痴的整個巨大鴻溝的可能性有多大,然後停留在人類天才的水平?” 他的回答是:“物理上可以製造出計算速度比人腦快一百萬倍的大腦……如果人類思維因此加速,那麼在外界每 31 秒的物理時間裡,主觀上就可以完成一年的思考,而一千年將在八個半小時內飛逝而過。” 尤德科夫斯基認為,如果我們現在不控制住局面,就為時已晚:“人工智慧以與你不同的時間尺度執行;當你的神經元完成思考‘我應該做點什麼’這句話時,你已經輸了。”

範例是牛津大學哲學家尼克·博斯特羅姆在他的《超級智慧》一書中提出的所謂的回形針最大化者的思想實驗:一個人工智慧被設計用來製造回形針,在耗盡其最初的原材料供應後,它會利用任何觸手可及的原子,包括人類。正如他在 2003 年的一篇論文中描述的那樣,從那裡它“開始首先將整個地球,然後將越來越多的空間部分轉變為回形針製造設施。” 不久之後,整個宇宙都由回形針和回形針製造者組成。

關於支援科學新聞業

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞業 訂閱。 透過購買訂閱,您正在幫助確保有關當今塑造我們世界的發現和想法的具有影響力的故事的未來。

我對此持懷疑態度。 首先,所有此類末日情景都涉及一系列的如果-那麼的偶然事件,其中任何一點的失敗都會否定末日。 西英格蘭大學布里斯托爾電氣工程教授艾倫·溫菲爾德在 2014 年的一篇文章中這樣說:“如果我們成功構建了人類等效的人工智慧,如果該人工智慧完全理解了它的工作原理,並且如果它隨後成功地改進了自身以產生超智慧人工智慧,並且如果該超人工智慧,意外地或惡意地,開始消耗資源,並且如果我們未能拔掉插頭,那麼,是的,我們很可能會遇到問題。 風險雖然並非不可能,但可能性不大。”

其次,人工智慧的發展速度遠低於預測,從而有時間在每個階段構建檢查機制。 正如谷歌執行董事長埃裡克·施密特在回應馬斯克和霍金時所說:“你不認為人類會注意到這種情況發生嗎? 你不認為人類會然後去關閉這些計算機嗎?” 谷歌自己的 DeepMind 已經開發出人工智慧關閉開關的概念,有趣地描述為在人工智慧接管嘗試事件發生時要按下的“紅色大按鈕”。 正如百度副總裁吳恩達所說(在對馬斯克的諷刺中),這“就像擔心火星上的人口過剩,而我們甚至還沒有踏上這顆星球一樣。”

第三,人工智慧末日情景通常基於自然智慧和人工智慧之間的錯誤類比。 正如哈佛大學實驗心理學家史蒂芬·平克在他對 2015 年 Edge.org 年度問題“你如何看待會思考的機器?”的回答中闡明的那樣:“人工智慧反烏托邦將狹隘的阿爾法男性心理投射到智慧的概念上。 他們假設超人智慧機器人會發展出諸如廢黜他們的主人或接管世界之類的目標。” 平克建議,同樣有可能“人工智慧將沿著女性路線自然發展:完全有能力解決問題,但沒有消滅無辜者或統治文明的慾望。”

第四,計算機“想要”做某事(例如將世界變成回形針)的含義意味著人工智慧有情感,但正如科學作家邁克爾·喬羅斯特指出,“一旦人工智慧想要任何東西,它將生活在一個有獎勵和懲罰的宇宙中——包括我們對它行為不端的懲罰。”

鑑於末日預測的歷史成功率為零,再加上人工智慧在過去幾十年中逐步發展,我們有足夠的時間來構建故障安全系統,以防止任何此類人工智慧末日。