對普通人來說,人工智慧領域似乎正在取得巨大進步。根據一些溢美之詞的媒體報道和新聞稿,OpenAI 的 DALL-E 2 似乎可以根據任何文字建立壯觀的影像;另一個名為 GPT-3 的 OpenAI 系統可以談論幾乎任何事情——甚至可以寫關於它自己的文章;而 Alphabet 旗下部門 DeepMind 於 5 月釋出的一個名為 Gato 的系統,據報道在公司可以拋給它的每項任務上都表現良好。DeepMind 的一位高階主管甚至吹噓,在創造具有人類智慧的靈活性和足智多謀性的人工智慧(稱為人工智慧通用性,或 AGI)的競賽中,“遊戲已經結束了。”

不要被愚弄了。機器可能有一天會像人類一樣聰明,甚至更聰明,但遊戲遠未結束。在製造真正能夠理解和推理周圍世界的機器方面,還有大量工作要做。我們現在需要的是少一些姿態,多一些基礎研究。

人工智慧正在取得進展——合成影像看起來越來越逼真,語音識別通常可以在嘈雜的環境中工作——但我們可能還需要幾十年才能實現通用、人類水平的人工智慧,它可以理解文章和影片的真正含義,或者應對意外的障礙和中斷。該領域仍然受困於學術科學家(包括我自己)多年來一直指出的同樣挑戰:使人工智慧可靠並使其能夠應對異常情況。

關於支援科學新聞報道

如果您喜歡這篇文章,請考慮透過以下方式支援我們屢獲殊榮的新聞報道 訂閱。透過購買訂閱,您正在幫助確保有關塑造我們當今世界的發現和想法的具有影響力的故事的未來。

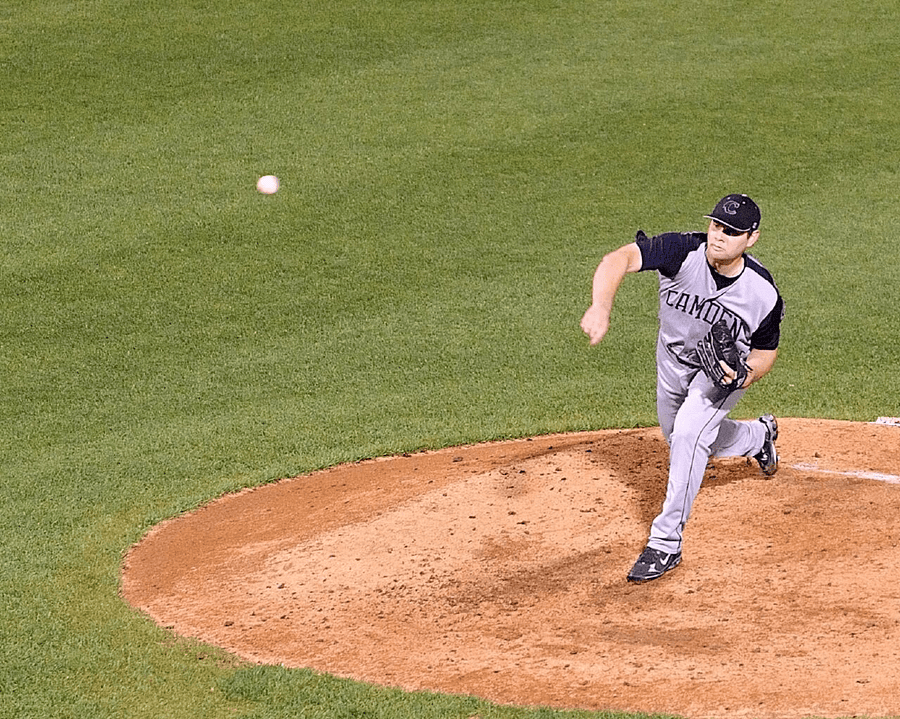

圖片來源:Bluesguy from NY/Flickr (CC BY-ND 2.0)

以最近備受讚譽的Gato(據稱是萬事通)為例,以及它是如何為一位投手投擲棒球的影像(上方)新增標題的。該系統的首要三個猜測是

一位棒球運動員在棒球場上投球。 一個男人在棒球場上向投手投擲棒球。 一位擊球手在擊球,一位捕手在棒球比賽期間位於土堆中。

第一個回答是正確的,但其他兩個答案包括了影像中沒有的其他球員的幻覺。除了從與其他影像的統計相似性中得出的粗略近似值之外,該系統不知道圖片中實際有什麼。任何棒球迷都會認出這是一個剛剛投出球的投手,而不是相反。儘管我們預計附近會有捕手和擊球手,但他們顯然沒有出現在影像中。

同樣,DALL-E 2 無法區分紅色立方體在藍色立方體之上與藍色立方體在紅色立方體之上的影像。今年 5 月釋出的較新系統,無法區分宇航員騎馬和馬騎宇航員。

當谷歌研究人員提示該公司的 AI Imagen 生成“宇航員騎馬”的影像時,它反而呈現了宇航員騎馬的影像。圖片來源:Imagen

當像 DALL-E 2 這樣的影像建立系統出錯時,結果可能很有趣。但有時人工智慧產生的錯誤會造成嚴重後果。一輛特斯拉自動駕駛汽車最近直接駛向一位在馬路中間拿著停車標誌的人工工人,只有當人類駕駛員介入時才減速。該系統可以識別單獨的人類(這是他們在訓練資料中出現的方式)和通常位置的停車標誌(正如他們在訓練影像中出現的那樣),但在遇到兩者不熟悉的組合時未能減速,這使得停車標誌處於新的和不尋常的位置。

不幸的是,這些系統仍然無法可靠工作並且難以應對新情況的事實通常被埋沒在細則中。例如,Gato 在 DeepMind 報告的所有任務上都表現良好,但很少像其他當代系統那樣出色。GPT-3 經常建立流暢的散文,但在基本算術方面存在困難,並且對現實的把握非常薄弱,以至於容易產生諸如“一些專家認為,吃襪子的行為有助於大腦從冥想導致的意識改變狀態中恢復過來”這樣的句子。然而,粗略地看一下最近的頭條新聞,你不會知道任何這些問題。

這裡的副線劇情是,最大的人工智慧研究團隊不再出現在學術界(同行評審曾是學術界的通行貨幣),而是出現在公司中。與大學不同,公司沒有公平競爭的動機。他們沒有將他們引人注目的新論文提交給學術審查,而是採取了新聞稿釋出的方式,引誘記者並繞過同行評審過程。我們只知道公司想讓我們知道的事情。

在軟體行業中,有一個詞來形容這種策略:“演示軟體”,即旨在在演示中看起來不錯,但未必足夠好用於現實世界的軟體。通常,演示軟體會變成“期貨軟體”,宣佈出來是為了震懾和敬畏,以阻止競爭對手,但從未真正釋出。

不過,報應終會來臨。冷核聚變可能聽起來很棒,但你仍然無法在商場買到它。人工智慧可能會經歷一段期望值降低的寒冬。太多的產品,例如無人駕駛汽車、自動化放射科醫生和通用數字助理,已經過演示、宣傳——但從未交付。目前,投資資金仍在基於承諾湧入(誰不喜歡無人駕駛汽車呢?)。但是,如果不可靠和無法應對異常值的核心問題得不到解決,投資將會枯竭。我們可能會在機器翻譯以及語音和物體識別方面取得紮實的進展,但相對於所有過早的炒作而言,其他方面卻乏善可陳。我們將不會得到“智慧”城市和“民主化”的醫療保健,而是會留下破壞性的深度偽造和排放大量碳的耗能網路。

儘管深度學習提高了機器識別資料模式的能力,但它有三個主要缺陷。它學習的模式具有諷刺意味的是膚淺而非概念性的;它建立的結果難以解釋;並且結果難以在其他過程(例如記憶和推理)的上下文中使用。正如哈佛大學計算機科學家萊斯·瓦利安特所指出的,“[未來的]中心挑戰是統一...學習和推理的表述。” 如果你不真正理解停車標誌是什麼,你就無法處理一個人拿著停車標誌的情況。

目前,我們陷入了“區域性最小值”,公司追求的是基準而不是基礎思想。當前的工程實踐遠遠領先於科學技能:這些部門專注於利用他們已經擁有的、理解不充分的工具來勉強取得小幅改進,而不是開發具有更清晰理論基礎的新技術。這就是為什麼基礎研究仍然至關重要。大部分人工智慧研究界(例如那些高呼“遊戲結束”的人)甚至沒有看到這一點,這真是令人心碎。

想象一下,如果某個外星人僅透過觀察地面上的陰影來研究所有人類互動,值得稱讚的是,它注意到有些陰影比其他陰影更大,並且所有陰影在夜間都會消失。也許它甚至會注意到陰影在某些週期性間隔內有規律地增長和縮小——但從未抬頭看到太陽或識別出上方的 3D 世界。

現在是人工智慧研究人員從引人注目的、直接面向媒體的演示中抬起頭來,詢問關於如何構建能夠同時學習和推理的系統的基本問題的時候了。